Am obținut rezultate de ultimă generație pentru o suită de sarcini lingvistice diverse, cu un sistem scalabil, agnostic de sarcini, pe care îl lansăm, de asemenea. Abordarea noastră este o combinație a două idei existente: transformatoare și pregătire preliminară nesupravegheată. Aceste rezultate oferă un exemplu convingător că împerecherea metodelor de învățare supravegheate cu pregătirea nesupravegheată funcționează foarte bine; aceasta este o idee pe care mulți au explorat-o în trecut și sperăm că rezultatul nostru va motiva cercetări suplimentare în aplicarea acestei idei pe seturi de date mai mari și mai diverse.

Citiți codul PaperView

| SNLI | Măsurare textuală | 89.3 | 89,9 |

| Potrivit MNLI | Măsurare textuală | 80.6 | 82.1 |

| MNLI nepotrivit | Măsurare textuală | 80.1 | 81.4 |

| SciTail | Măsurare textuală | 83.3 | 88.3 |

| QNLI | Măsurare textuală | 82.3 | 88.1 |

| RTE | Măsurare textuală | 61.7 | 56.0 |

| STS-B | Asemănare semantică | 81,0 | 82,0 |

| QQP | Asemănare semantică | 66.1 | 70.3 |

| MRPC | Asemănare semantică | 86,0 | 82.3 |

| RASĂ | Înțelegerea lecturii | 53.3 | 59.0 |

| ROCStories | Raționament Commonsense | 77,6 | 86,5 |

| COPA | Raționament Commonsense | 71.2 | 78,6 |

| SST-2 | Analiza sentimentelor | 93.2 | 91.3 |

| CoLA | Acceptabilitate lingvistică | 35.0 | 45.4 |

| LIPICI | Etalon de referință pentru mai multe sarcini | 68,9 | 72,8 |

Sistemul nostru funcționează în două etape; mai întâi pregătim un model de transformator pe o cantitate foarte mare de date într-o manieră nesupravegheată - folosind modelarea limbajului ca semnal de antrenament - apoi ajustăm acest model pe seturi de date supravegheate mult mai mici pentru a-l ajuta să rezolve sarcini specifice. Am dezvoltat această abordare urmărind munca noastră de neuroni sentimentali, în care am observat că tehnicile de învățare nesupravegheate pot produce caracteristici surprinzător de discriminative atunci când sunt instruiți cu suficiente date. Aici am vrut să explorăm în continuare această idee: putem dezvolta un singur model, să-l instruim într-un mod nesupravegheat pe o cantitate mare de date și apoi să-l reglăm fin pentru a obține performanțe bune în multe sarcini diferite? Rezultatele noastre indică faptul că această abordare funcționează surprinzător de bine; același model de bază poate fi reglat pentru sarcini foarte diferite, cu o adaptare minimă.

Această lucrare se bazează pe abordarea introdusă în învățarea secvențială semi-supravegheată, care a arătat cum să îmbunătățim performanțele clasificării documentelor prin utilizarea pre-instruirii nesupravegheate a unui LSTM urmată de reglarea fină supravegheată. De asemenea, extinde ULMFiT, cercetare care arată cum un singur model de limbaj LSTM agnostic cu set de date poate fi reglat fin pentru a obține performanțe de ultimă generație pe o varietate de seturi de date de clasificare a documentelor; munca noastră arată cum un model bazat pe Transformer poate fi utilizat în această abordare pentru a reuși la o gamă mai largă de sarcini dincolo de clasificarea documentelor, cum ar fi raționamentul bunului simț, similitudinea semantică și înțelegerea lecturii. Este, de asemenea, similar cu dar mai agnostic de sarcini decât ELMo, care încorporează pregătirea prealabilă, dar folosește arhitecți personalizați pentru a obține rezultate de ultimă generație într-o suită largă de sarcini.

Foarte puțină reglare a fost folosită pentru a obține rezultatele noastre. Toate seturile de date utilizează un singur model de limbaj direct, fără niciun ansamblu, iar majoritatea rezultatelor raportate utilizează exact aceleași setări de hiperparametru.

Un rezultat de care suntem deosebit de entuziasmați este performanța abordării noastre pe trei seturi de date - COPA, RACE și ROCStories - concepute pentru a testa raționamentul comun și înțelegerea lecturii. Modelul nostru obține noi rezultate de ultimă generație pe aceste seturi de date cu o marjă largă. Se consideră că aceste seturi de date necesită raționamente multi-propoziții și cunoștințe semnificative ale lumii pentru a rezolva, sugerând că modelul nostru îmbunătățește aceste abilități în principal prin învățare nesupravegheată. Acest lucru sugerează că există speranță pentru dezvoltarea capacităților complexe de înțelegere a limbajului prin tehnici nesupravegheate.

De ce învățarea nesupravegheată?

Învățarea supravegheată se află la baza majorității succesului recent al învățării automate. Cu toate acestea, poate necesita mari, curățate cu atenție și costisitoare pentru a crea seturi de date care să funcționeze bine. Învățarea fără supraveghere este atractivă datorită potențialului său de a aborda aceste dezavantaje. Întrucât învățarea nesupravegheată elimină blocajul etichetării explicite a omului, aceasta se potrivește bine cu tendințele actuale de creștere a calculului și disponibilitatea datelor brute. Învățarea fără supraveghere este un domeniu foarte activ de cercetare, dar utilizările practice ale acesteia sunt adesea încă limitate.

Recent s-a făcut o încercare de a încerca să îmbunătățească capacitățile lingvistice utilizând învățarea nesupravegheată pentru a spori sistemele cu cantități mari de date neetichetate; reprezentările cuvintelor antrenate prin tehnici nesupravegheate pot utiliza seturi de date mari, formate din terabyți de informații și, atunci când sunt integrate cu învățarea supravegheată, pot îmbunătăți performanța pentru o gamă largă de sarcini NLP. Până de curând, aceste tehnici nesupravegheate pentru NLP (de exemplu, GLoVe și word2vec) foloseau modele simple (vectori de cuvinte) și semnale de antrenament (co-apariția locală a cuvintelor). Skip-Thought Vectors este o demonstrație timpurie notabilă a potențialelor îmbunătățiri pe care abordările mai complexe le pot realiza. Dar sunt folosite acum tehnici noi care sporesc în continuare performanța. Acestea includ utilizarea de modele de reprezentare a propozițiilor pre-instruite, vectori de cuvinte contextualizați (în special ELMo și CoVE) și abordări care utilizează arhitecți personalizați pentru a contopi pregătirea nesupravegheată cu reglarea fină supravegheată, precum a noastră.

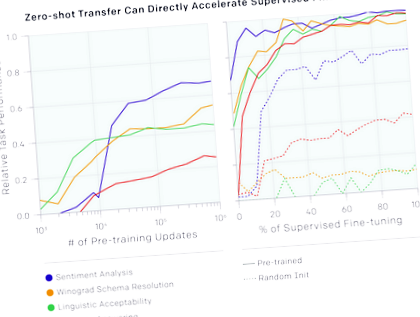

De asemenea, am observat că putem folosi modelul lingvistic care stă la baza pentru a începe să îndeplinim sarcini fără să ne antrenăm vreodată. De exemplu, performanța în sarcini precum alegerea răspunsului corect la o întrebare cu alegere multiplă crește constant pe măsură ce modelul lingvistic de bază se îmbunătățește. Deși performanța absolută a acestor metode este încă adesea destul de scăzută în comparație cu starea de artă supravegheată (pentru întrebări, răspunsul la acesta este încă depășit de o simplă linie de bază cu fereastră glisantă) este încurajator faptul că acest comportament este robust într-un set larg de sarcini. Rețelele inițializate aleatoriu care nu conțin informații despre sarcină și lumea nu au rezultate mai bune decât aleatorii folosind aceste euristici. Acest lucru oferă o oarecare înțelegere a motivului pentru care preinstruirea generativă poate îmbunătăți performanța în sarcinile din aval.

De asemenea, putem folosi funcționalitatea de limbă existentă în model pentru a efectua analize de sentiment. Pentru setul de date Stanford Sentiment Treebank, care constă din propoziții din recenzii de filme pozitive și negative, putem folosi modelul lingvistic pentru a ghici dacă o recenzie este pozitivă sau negativă introducând cuvântul „foarte” după propoziție și văzând dacă modelul prezice cuvântul „pozitiv” sau „negativ” ca fiind mai probabil. Această abordare, fără a adapta deloc modelul la sarcină, are performanțe egale cu liniile de bază clasice

Munca noastră este, de asemenea, o validare a robusteții și utilității arhitecturii transformatorului, indicând faptul că este suficient de flexibilă pentru a obține rezultate de ultimă generație pentru o gamă largă de sarcini, fără a necesita personalizare complicată specifică sarcinii sau reglare hiperparametru.

Dezavantaje

Acest proiect are câteva probleme restante, care merită menționate:

Viitor

- Scalarea abordării: Am observat că îmbunătățirile în performanța modelului lingvistic sunt bine corelate cu îmbunătățirile sarcinilor din aval. În prezent utilizăm hardware de bază (o singură mașină de 8 GPU) și un set de date de instruire de doar câteva mii de cărți

5 GB de text). Acest lucru sugerează că există un loc semnificativ de îmbunătățire utilizând abordarea bine validată a mai multor calcule și date.

Anexă: Exemple de seturi de date

Fata i-a înapoiat scrisoarea poștașului pentru că:

Calcula

Suntem tot mai interesați să înțelegem relația dintre calculul pe care îl cheltuim pe modele de instruire și rezultatul rezultat. Calculul total utilizat pentru antrenarea acestui model a fost de 0,96 zile petaflop (pfs-zile).

- Învățarea limbilor străine și dietele - mai asemănătoare decât crezi

- Îmbunătățirea recomandărilor dietetice pentru pacienții cu diabet de tip 2 și obezitate într-o endocrinologie

- Îmbunătățirea comportamentului alimentar eficiența mesajelor personalizate în setările de îngrijire primară - PubMed

- Îmbunătățirea motivației exercițiului de rulare pentru reducerea greutății corporale prin scăderea

- Îmbunătățirea nutriției pentru a sprijini îmbătrânirea sănătoasă care sunt oportunitățile de intervenție