Revizuire

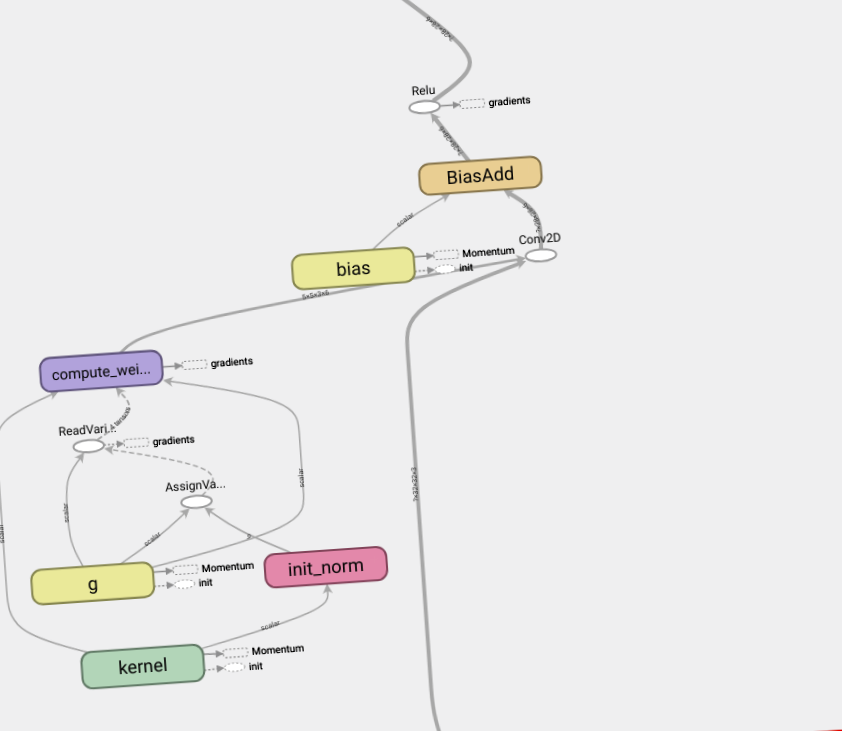

Acest caiet va demonstra cum să utilizați stratul de normalizare a greutății și cum poate îmbunătăți convergența.

Parametrizare simplă pentru a accelera învățarea rețelelor neuronale profunde:

Tim Salimans, Diderick P. Kingma (2016)

Modificând astfel parametrii greutăților, îmbunătățim condițiile problemei de optimizare și accelerăm convergența coborârii gradientului stochastic. Re-parametrizarea noastră se bazează pe normalizarea batch, dar nu introduce dependențe între exemplele din mini-pachet. Aceasta înseamnă că metoda noastră poate fi aplicată cu succes și modelelor repetitive, cum ar fi LSTM, și aplicațiilor sensibile la zgomot, cum ar fi antrenamentul de armare profundă sau modelele generative, pentru care normalizarea lotului este mai puțin adecvată. Deși metoda noastră este mult mai simplă, oferă în continuare o mare parte din accelerarea normalizării complete a lotului. În plus, costurile de calcul ale metodei noastre sunt mai mici, ceea ce vă permite să efectuați mai mulți pași de optimizare în același timp.

Personalizați

Construiește modele

Încărcați date

Modele de tren

Cu excepția cazului în care se menționează altfel, conținutul acestei pagini este licențiat sub licența Creative Commons Attribution 4.0, iar mostrele de cod sunt licențiate sub licența Apache 2.0. Pentru detalii, consultați Politicile site-ului Google Developers. Java este o marcă înregistrată a Oracle și/sau a afiliaților săi.

- Întrebare despre greutate Forumurile Academiei de Servicii din Statele Unite ale Americii

- Tratament Cel mai bun OTC Www Enu pentru o scădere în greutate Paleo Diet Diet High Protein Diet Menu Plan pentru scăderea în greutate

- Dieta cu supă - Eco Slim

- Arhiva de reducere a greutății - National Lightning Owners Club Inc

- Soluția pentru pierderea permanentă în greutate, sigură și sănătoasă